- Введение

- Количество символов в одном токене

- Стоимость одного токена

- Почему увеличение контекста диалога увеличивает стоимость

- Как экономить токены?

- Заключение

OpenAI, разработчик моделей на основе GPT (Generative Pretrained Transformer), определяет стоимость использования своих моделей в токенах. Чтобы понять, как расходуются токены и какова их стоимость, важно рассмотреть ключевые аспекты системы токенизации и тарификации.

Токен не является постоянной величиной символов. В зависимости от языка и контекста, один токен может варьироваться от одного символа до, примерно, пятидесяти слов. В среднем, считается, что один токен равняется примерно четырем символам английского текста. Однако это не строгое правило, поскольку токенизатор моделей GPT структурирует токены, исходя из общего контекста и частоты использования слова или фразы. Следовательно, некоторые токены могут представлять всего один символ (например, пунктуацию), в то время как другие - целые слова или словосочетания.

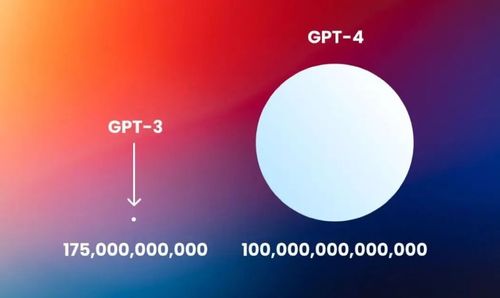

Стоимость токена в чате GPT задается в соответствии с выбранным тарифным планом и может различаться в зависимости от версии модели GPT. Стоит отметить, что версия GPT-4 расходует, в среднем, в 12 раз больше токенов, чем ее предшественник.

Размер контекста диалога напрямую влияет на количество расходуемых токенов. Контекст диалога - это весь текст, который модель учитывает при генерации ответа. Более обширный контекст требует большего числа токенов только для его анализа, плюс сам сгенерированный ответ также добавляет дополнительные токены.

Примером может служить диалог, где каждый последующий запрос и ответ строится на предыдущем обмене сообщениями. Если размер контекста превышает определенный лимит, модель не сможет учесть его полностью из-за ограничения на максимальное количество токенов, которые она может обработать за один раз. И в результате выдаст ошибку или пустой ответ.

Как результат, увеличение контекста диалога, который модель видит перед генерацией ответа, увеличивает общее количество токенов, подлежащих оплате. Это справедливо для продолжительных диалогов или когда пользователь ожидает, что модель учтет значительное количество предыдущего текста для поддержания согласованности и релевантности ответов.

- Четко формулируйте запросы: избегайте лишних слов и уточняющих фраз.

- Используйте упрощенную и конкретную лексику без сложной терминологии, если это не требуется для контекста.

- Минимизируйте использование пунктуации, когда это возможно, не нарушая смысла.

- Избегайте повторений и тавтологии, используя анафорические ссылки (он, она, это) или синонимы.

- Разбивайте большие запросы на несколько маленьких, чтобы контролировать количество токенов за каждую итерацию.

Расход токенов и, соответственно, стоимость запросов в ChatGPT напрямую связаны с количеством обрабатываемого текста. Более длинные запросы и ответы требуют большего числа токенов, что увеличивает стоимость. Использование моделей требует внимания к оптимизации текстового ввода и учету общего размера контекста для эффективного и экономного использования ресурсов AI.

Chat4

Chat4